Écrit par Olivier Beltramo-Martin

Compar:ia : une plateforme pour comparer les IA conversationnelles

Le Ministère de la Culture et la Direction Interministérielle du Numérique (DINUM) ont lancé en octobre 2024 la plateforme Compar:ia visant à comparer des assistants conversationnels basés sur des grands modèles de langage.

Nous y retrouvons nos bêtes de foire préférées comme GPT-4o d’OpenAI, Llama3.1-405B de Meta, DeepSeek-v3 de la société éponyme ou encore Mistral Large de notre licorne française, ainsi que d’autres moins connues.

Un outil de comparaison innovant

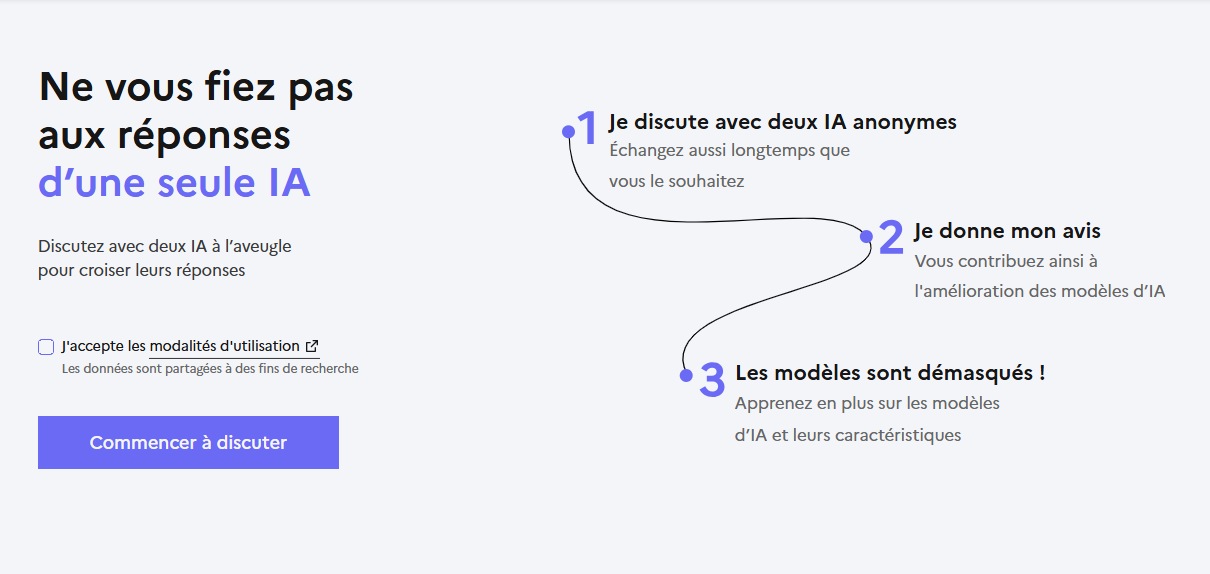

L’objectif : comparer deux assistants à l’aveugle sur des questions de votre choix et évaluer leurs réponses respectives.

Je trouve cette démarche pertinente et utile pour plusieurs raisons :

✔ La plateforme est très accessible et facilite l’accès à des assistants pour en démocratiser l’usage raisonné et sensibiliser aux bonnes pratiques, comme le prompt engineering.

✔ L’évaluation se fait sur un cas concret (le vôtre) et sans a priori sur votre opinion des modèles qui ne sont pas connus lors de la phase d’évaluation par défaut.

✔ La plateforme offre la possibilité de comparer deux modèles pour se faire un avis plus précis selon son cas d’usage.

On remarquera d’ailleurs que les modèles open-source de Mistral et Meta sont plus souvent testés que les autres. Atol CD est à votre disposition pour les intégrer dans vos projets IA.

Amélioration des modèles et mesure de l’impact énergétique

Derrière tout ça, il y a le besoin de renforcer des (futurs) modèles IA en intégrant les préférences humaines dans les réponses pour ajouter ou supprimer des biais, en particulier dans un contexte où les LLMs sont essentiellement entraînés sur des corpus anglophones et propagent des biais linguistiques et culturels.

Enfin, Compar:ia donne un bilan énergétique de l’inférence des deux assistants, ce qui permet de mesurer leur consommation en W.h et leurs émissions de CO₂.

Sur la question : « Propose une méthode d’évaluation a priori de la consommation énergétique et de l’émission carbone associées à l’apprentissage, l’inférence et la maintenance d’un modèle d’apprentissage profond pour la classification d’espèces végétales. » j’ai comparé les réponses des modèles Llama3.1-8b et Llama3.1-405b.

Surprise, la réponse de la version 8B m’a mieux convenu que celle de son grand frère, avec une différence de taille sur la consommation : 7 W.h (8B) contre 251 W.h (405B).

Autrement dit, un modèle avec plus de paramètres n’est pas systématiquement un modèle qui répond mieux à vos préférences.

Évaluer un bilan énergétique et carbone n’est pas trivial, donc sur ces questions-là, optez plutôt pour Atol CD !

Laisser un commentaire